專為大眾而生的

一站式GenAI

落地訓練暨高效推論解決方案

方案介紹

量身打造,預算無負擔

輕鬆操作,一鍵部署

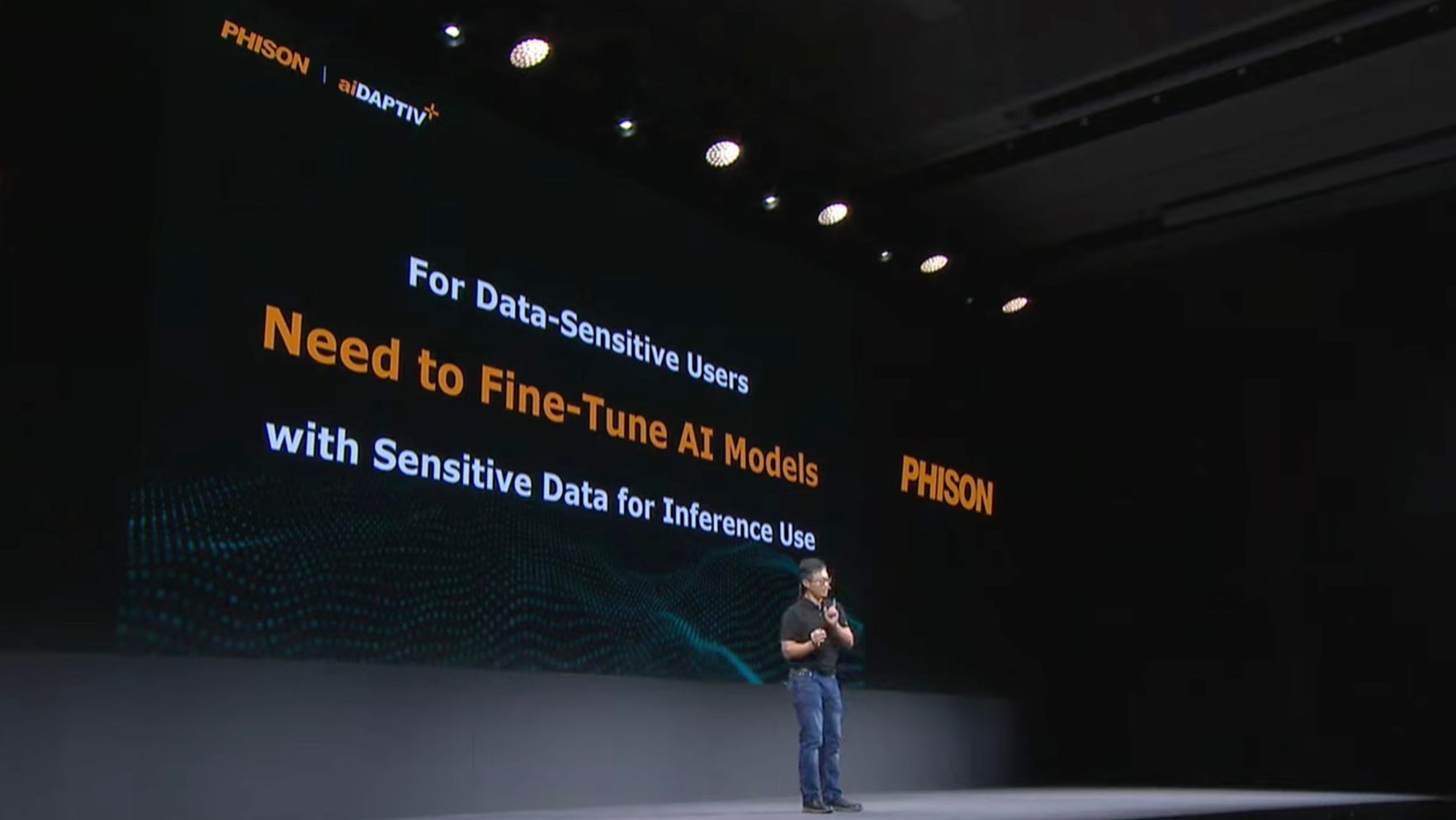

資料隱私,安全無慮

註:比較4張本地NVIDIA 6000 ADA GPU與8張雲端NVIDIA H100 GPU

經濟實惠

aiDAPTIV+ 能夠實現 HBM、GDDR 記憶體與成本效益更高的快閃記憶體之間的動態資源調配,有效降低硬體支出,同時大幅減少模型訓練對昂貴且耗電GPU顯示卡的需求

上手不費力

無論在家、辦公室、學校教室或資料中心都能輕鬆部署。體積小巧,只需使用一般的電力與冷卻設備。

支援指令列操作與直覺化圖形介面,內建多種功能套件,讓您輕鬆進行模型導入、微調、驗證及推理。

資料高度隱私

讓您在防火牆內進行大語言模型(LLM)訓練,全面掌控私密資料,確保符合資料隱私規範,讓您使用更安心。

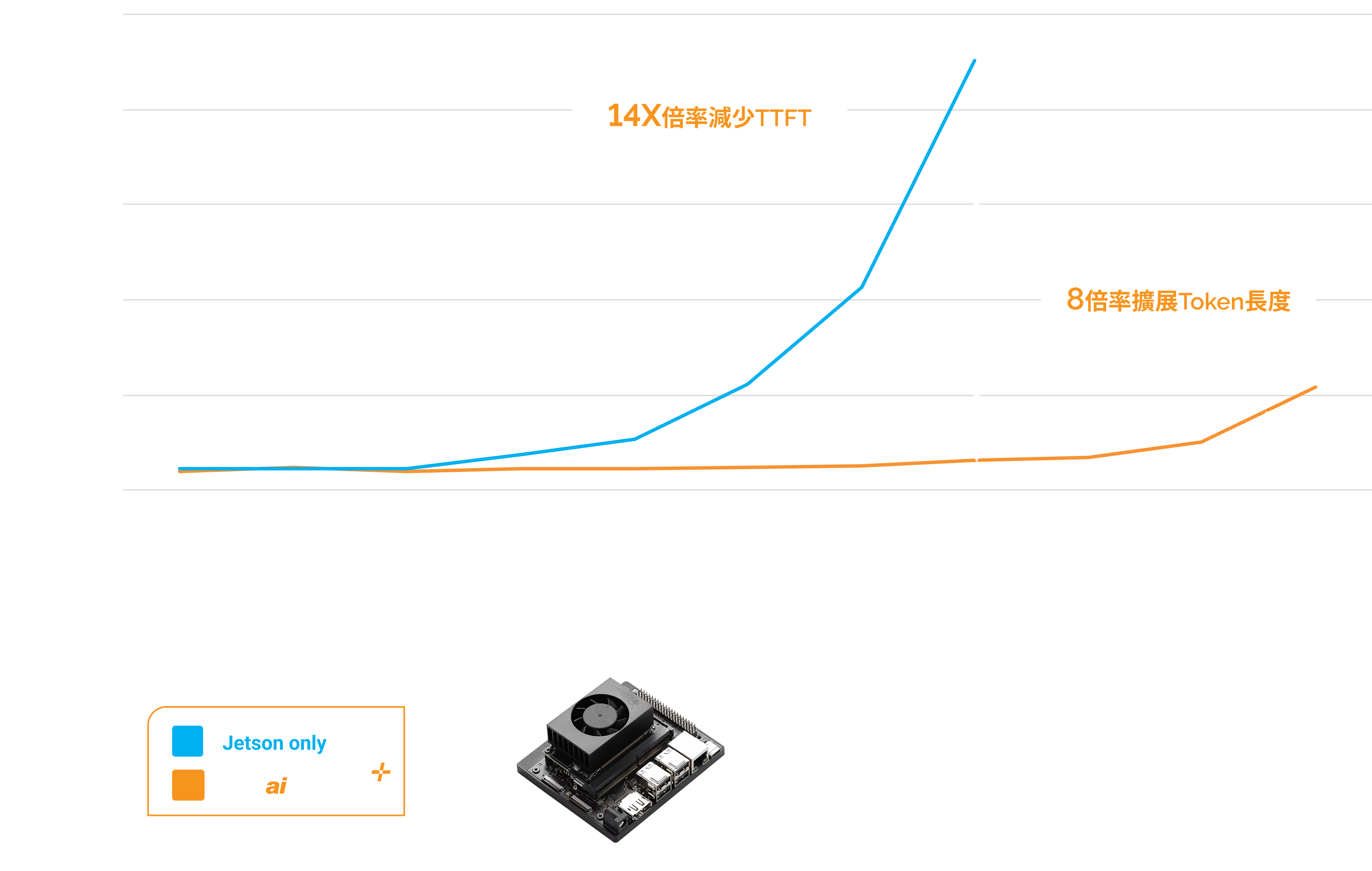

釋放IoT邊緣運算及機器人科技

NVIDIA Jetson IoT 裝置搭載群聯aiDAPTIV+ 技術,不僅能進行LLM訓練,還能加速首次token召回的時間,提高推論效能,以及通過增加token長度,增強上下文讀辨,提供更長且更精確的回答。

AI筆記型電腦

搭載 GPU 及群聯 aiDAPTIV+ 技術的 AI 筆記型電腦,讓使用者可在家中、辦公室或教室即可學習如何訓練LLM。此外,您也能在本地運行訓練過的 LLM,並透過模型擴充其資料,使其提供更為量身定制的推論應答。使用 aiDAPTIV+ 技術還能提升提示召回時間,並提供更多的上下文空間,進而產生更長且更精確的回覆。

群聯 aiDAPTIV+大語言模型訓練整合方案

使用指令列或aiDAPTIV+ Pro Suite進行LLM訓練

模型支援

- Llama, Llama-2, Llama-3, CodeLlama

- Vicuna, Falcon, Whisper, Clip Large

- Metaformer, Resnet, Deit base, Mistral, TAIDE

- 更多模型將持續加入

內建高效記憶體管理方案

體驗無縫的PyTorch相容性,無需調整AI應用程式,輕鬆新增節點。系統供應商可享有AI100E SSD、Middleware函式庫授權及群聯全方位支援,助您順利整合系統

優勢

- 無瑕置換

- 無需變更您的AI 應用

- 重複使用現有硬體或增加節點

aiDAPTIV+ 中介軟體

- 將模型分割,分配到每個GPU

- 在 aiDAPTIVCache 上暫放待處理的切片

- 將GPU上已完成的部分與待處理的切片交換

系統整合商權益

- ai100E SSD

- 中介軟體函式庫授權

- 群聯電子全方位支援服務

無縫擴展GPU記憶體

群聯aiDAPTIVCache及中介軟體可擴展 GPU 記憶體,為 PC 提供額外 320GB、工作站與伺服器上至8TB 的記憶體,支援低延遲的 LLM 訓練。此外,其更具備業界領先的 100 DWPD 極高耐久度,並於特殊設計中支援群聯的先進 NAND 糾錯演算法技術。

無縫整合

- 優化的中介軟體以擴展 GPU 記憶體容量

- 2x 2TB aiDAPTIVCache,支援70B模型

- 低延遲

高耐久度

- 業界領先,高達100次的五年內每日寫入次數(DWPD)

- 採用業界先進NAND 糾錯算法的SLC NAND

加強推論

aiDAPTIV+ 能通過加速首次召回Token的時間來實現更快速的回應,提升推論使用體驗,並同時延長 Token 長度,提供更豐富的上下文,從而生成更長且更準確的回答。

釋放模型無限潛能

aiDAPTIV+ 透過整合快閃記憶體與 DRAM,提供更大的記憶體資源,使模型規模不再受限於 GPU 顯示卡的 HBM 或 GDDR 記憶體容量

這讓您能夠訓練更大規模的模型,並以更實惠的方式運行過去只有大型企業和雲端服務供應商才能承擔的運算需求

其他資源

支援平台

業界支持

新聞集錦